検索で上位を獲得し続けるためには専門知識だけでなく、ユーザー体験とビジネスゴールを結び付ける思考が欠かせません。本記事では「SEO対策とは結局何を指すのか」を丁寧に分解し、いま押さえるべき最新トレンドと成果を最大化する運用プロセスを一気通貫でお伝えします。検索エンジンの評価基準は年々複雑化していますが、原理原則は「信頼できる情報を、適切な形で届ける」ことに集約されます。読了後には自社サイトの課題を特定し、次のアクションを即実践できるようになるはずです。

加えて、外部環境の変化—たとえば生成AIの台頭やプライバシー規制の強化—により検索行動そのものも変容しています。従来のキーワード偏重の施策では通用しない時代に、どのようにしてユーザーの検索意図を深く理解し、価値あるコンテンツへ昇華させるか。SEO担当者としての実務経験を踏まえ、抽象論ではなく「明日から使える改善手順」を中心に解説していきます。

目次

SEO対策を深掘りする前に: 基本の考え方

SEOの定義と重要性

SEO(Search Engine Optimization)とは、検索エンジンからの自然流入を増やすためにサイト構造やコンテンツを最適化する一連の施策を指します。「広告費を掛けずに長期的な集客基盤を構築できる」というメリットがある一方、成果の可視化までに時間を要するという特徴もあります。そのため、経営層を含む社内ステークホルダーに対しては、KPI設計とロードマップ提示が不可欠です。具体的には、検索需要の調査→サイト設計→コンテンツ制作→効果測定→改善のループを体系立てて示すことで、投資対効果を納得感を持って共有できます。

重要なのは、SEOが単なる集客チャネルではなく、ブランド価値を底上げする戦略要素であるという認識です。検索結果で常に上位を維持することで、ユーザーは無意識に企業の信頼度を評価します。その結果、広告以外からの流入にも好影響を及ぼし、指名検索や口コミ増加へ波及します。

また、SEOはコンテンツと技術の両輪で成り立つため、マーケティング部門と開発部門が横串で連携できるプロジェクトマネジメントが欠かせません。早期に役割分担を明確化し、週次で数値を共有する体制を整えることが成功の第一歩です。

検索エンジンの仕組みを噛み砕いて説明

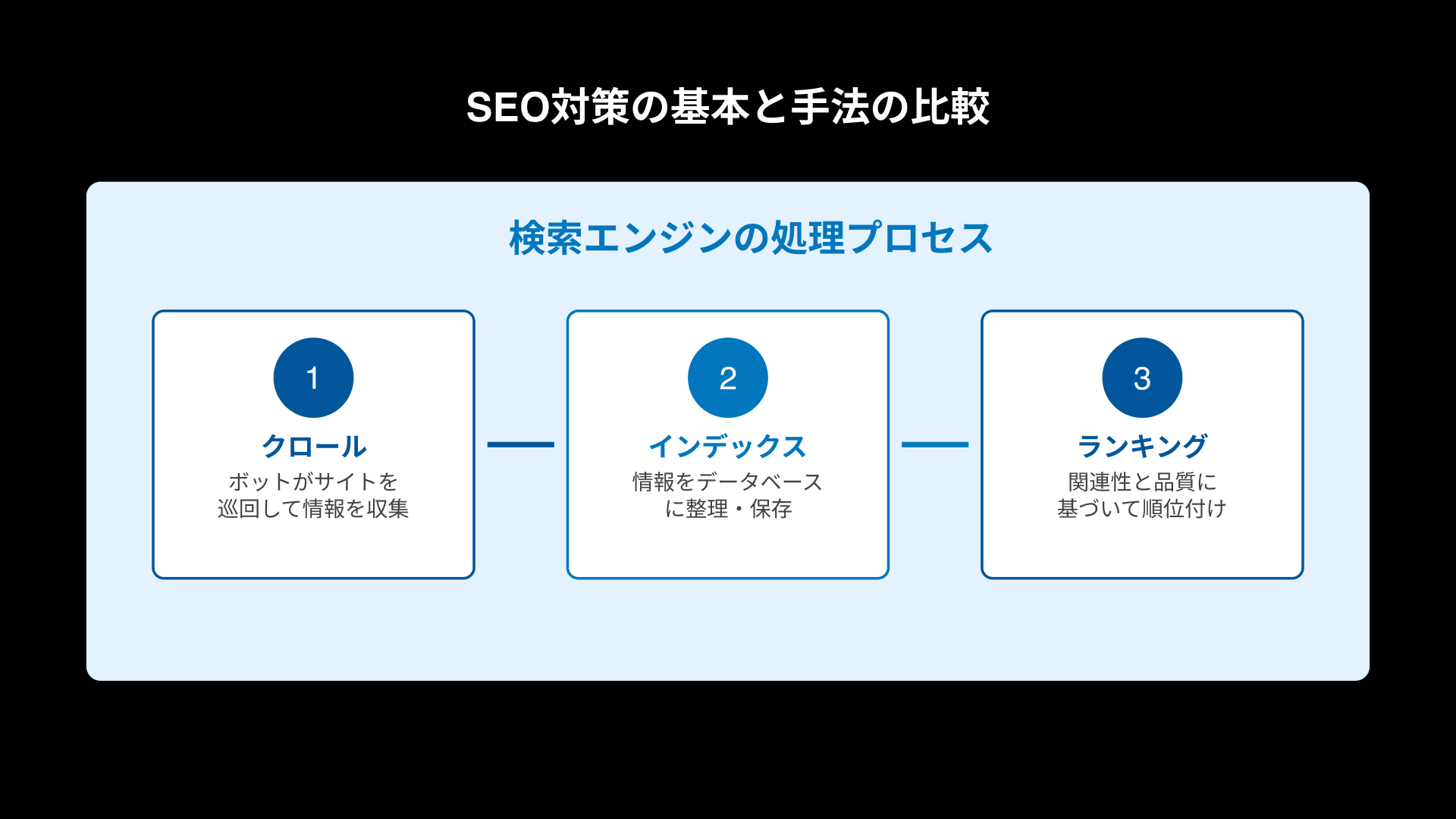

検索エンジンは「クロール」「インデックス」「ランキング」という三段階でウェブページを処理します。クロールとはロボットが URL を巡回して情報を収集する工程、インデックスは取得した情報をデータベースに整理する工程、ランキングは検索クエリに対して最も関連性と品質の高いページを順位付けする工程です。つまり、クロールされないページは検索結果に露出せず、インデックスされても品質シグナルが不足していれば上位表示されません。

内部リンク設計や XML サイトマップの提出はクロール効率の向上に寄与し、重複コンテンツや低品質ページを排除することはランキングシグナルを高める鍵となります。

クロールバジェットという概念も重要です。大規模サイトでは Googlebot が一度にクロールできる URL 数が限定されるため、不要なクエリパラメータを含むページやフィルタ生成 URL が氾濫すると、重要ページの発見が遅延します。robots.txt によるディスアローや noindex タグの活用で、クロール資源を重点ページへ集中させましょう。

また、レンダリング指向の SPA(Single Page Application)では、クライアントサイド JavaScript を Google が完全に解釈できないケースが依然あります。SSR(サーバーサイドレンダリング)や動的レンダリングの導入は、JavaScript リッチなフレームワーク利用サイトにとって必須の検討事項です。

ホワイトハットとブラックハットの違い

SEO施策は大きく「ホワイトハット(検索ガイドラインに準拠)」と「ブラックハット(ガイドライン違反)」に分類されます。かつては被リンクを大量購入するブラックハット手法が短期的に効果を発揮した時期もありましたが、アルゴリズムの進化によりリスクは急速に高まっています。ペナルティを受けるとドメイン全体の評価が長期にわたり毀損するため、正攻法であるホワイトハット戦略を選ぶことが現実的です。

ブラックハットが根絶されない理由は、短期的な成果を求めるビジネスインセンティブに他なりません。しかしながら、検索アルゴリズムはリアルタイムでスパム行為を検出する能力を高めており、手動ペナルティだけでなく自動減点も増加傾向です。長期的視野で見れば、ガイドラインに沿った施策の方が ROI は高くなります。

一方、ホワイトハットの中でも「グレーゾーン」とされるテクニックが存在します。たとえば被リンク目的の寄稿記事は、内容がユーザーに価値を提供しない場合スパム判定を受ける可能性があります。施策を実行する際は『検索品質評価ガイドライン』および『リンクスパムポリシー』を読み込み、自社のリスク許容度を明確にしておくことが重要です。

最新SEO施策の全貌

E‑E‑A‑Tに基づくコンテンツ制作

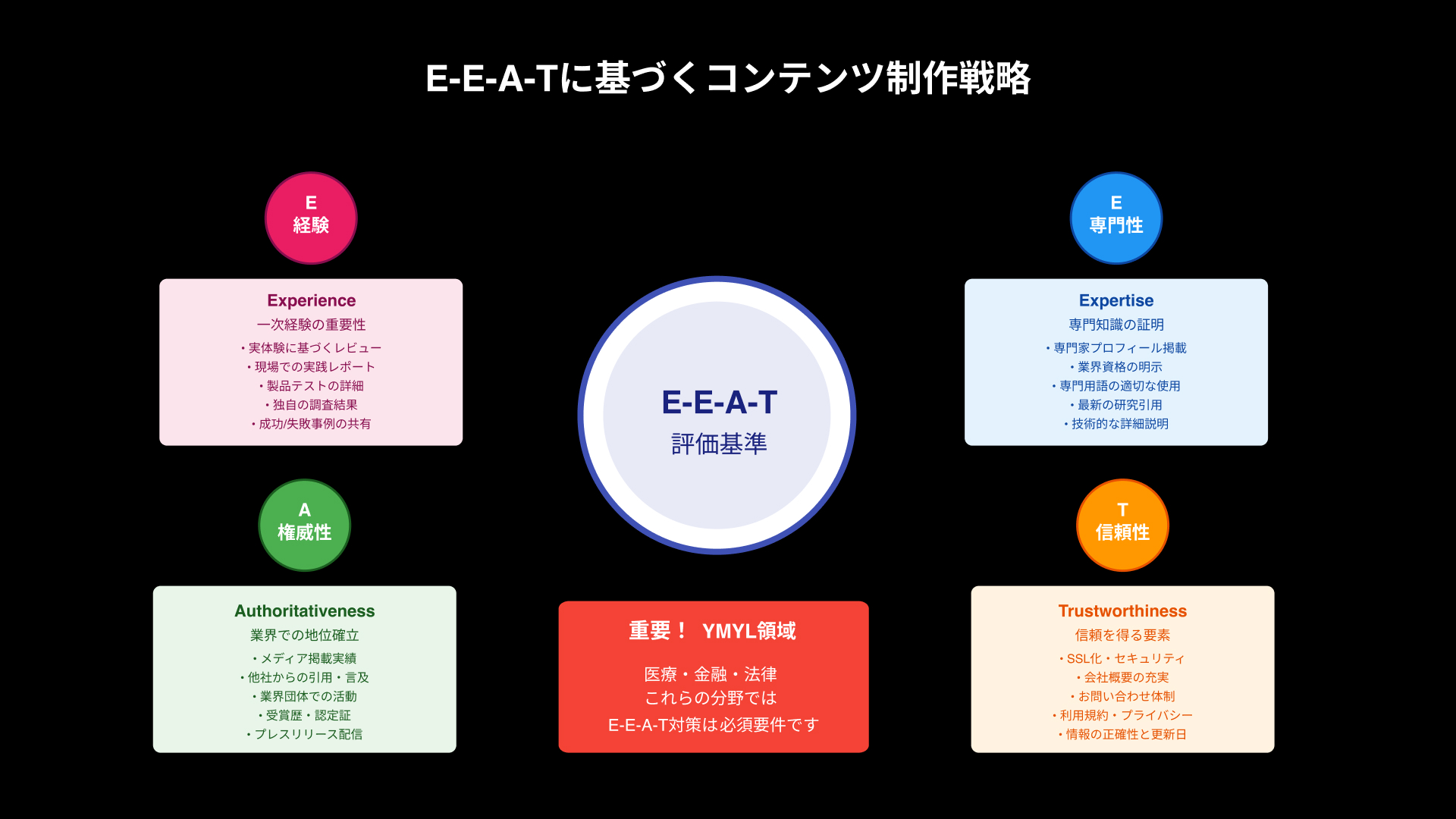

Google は「Experience・Expertise・Authoritativeness・Trust(E‑E‑A‑T)」を重視すると公言しています。特に医療・金融など YMYL(Your Money or Your Life)領域では、一次情報や専門家監修が欠かせません。ライターと監修者のプロフィールを明示し、一次データを引用し、考察を加えることで信頼性が向上します。また実体験を含む「一次経験(Experience)」は他サイトが模倣しづらく差別化に直結します。さらに FAQ 構造化データやアバウトページで企業実績を示すことで、オーソリティシグナルを補完できます。

E‑E‑A‑T を強化するためには、第三者メディアからの言及や被リンクも有効です。プレスリリース配信後に業界紙へ転載されるケースや、大学との共同研究成果をホワイトペーパーとして公開する施策は高評価を得やすい事例です。これらはコンテンツ単体の質を高めるだけでなく、ドメイン全体の信頼性を底上げします。

執筆体制にも工夫が必要です。社内専門家をライターと組ませ、現場のナレッジをコンテンツへ落とし込む「ハイブリッドライティング」は、専門性と一次経験を同時に担保できるため効果的です。編集者は専門家の用語を一般ユーザー向けに翻訳し、可読性を高める役割を担います。

Core Web VitalsによるUX最適化

2024年のアップデートで Google は Core Web Vitals の指標を刷新し、INP(Interaction to Next Paint)を正式採用しました。これはユーザー操作後の応答時間を測る指標で、従来の FID より UX に直結します。具体的な改善策としては、JavaScript の分割読み込み、クラウド型 CDN の利用、画像の次世代フォーマット化(WebP・AVIF)などが挙げられます。実装後は PageSpeed Insights と Chrome User Experience Report で指標を計測し、75 パーセンタイルが「良好」判定になるまで継続的にチューニングしましょう。

リソースの遅延読み込みに加え、重要レンダリングパスの短縮も忘れてはいけません。クリティカル CSS をインライン化し、フォント表示を非同期化することで FCP(First Contentful Paint)と LCP(Largest Contentful Paint)を同時に改善できます。また、画像の aspect-ratio を指定してレイアウトシフトを防止し、CLS(Cumulative Layout Shift)を最適化しましょう。

一方で、パフォーマンス改善が直接的にランキング向上へ寄与する度合いはクエリの種類によって異なります。ニュース系の速報クエリやモバイルユーザー比率が高いローカルビジネスクエリでは、速度向上の ROI が高い傾向にあります。GA4 で端末別流入割合を確認し、優先度を戦略的に設定することが望まれます。

AI時代のキーワードリサーチと検索意図解析

生成AIの普及により、ユーザーは従来より長文で具体的な質問を投げかける傾向が強まりました。その結果、検索キーワードはより会話的になり、検索意図の解像度を高く捉える必要があります。具体的には、検索ボリュームだけでなく「PAA(People Also Ask)」やディスカバリーサジェストを併用し、多角的にユーザー課題を抽出します。またトピッククラスターモデルを導入し、メインテーマと関連サブトピックを内部リンクで網羅的に接続することで、クローラビリティと専門性の両立が図れます。

検索意図は「Know」「Do」「Go」「Buy」の 4 分類モデルだけでなく、その奥にある心理的ニーズを理解することが重要です。カスタマージャーニーを描き、各段階で求められる情報粒度を整理した上でキーワードマッピングを行うと、CVR 向上に直結する導線を構築できます。

SEO成果の測定と改善ループ

KPI設定と効果測定ツール(GSC・GA4)

SEO施策の効果測定では「順位」「クリック数」「コンバージョン」の三層で指標を設定します。検索需要が大きいクエリは順位と CTR の関係が売上に直結するため、Search Console のクエリレポートを日次でモニタリングし、閾値を下回った場合はリライトを即時検討します。また、GA4 ではランディングページ別のエンゲージメント率とイベントコンバージョンを確認し、情報の網羅性と CTA 配置の適切性を評価します。KPI は SMART 原則に従い、四半期単位で再定義することで組織全体の目標整合性を担保できます。

BtoB 領域では、検索流入後すぐにコンバージョンが起こらないケースが多いため、「資料請求」「ウェビナー申込」など中間 CV の指標も同時に追跡します。これにより、ファネル上部からの貢献度を可視化し、広告施策との最適配分を判断できます。

指標の可視化には Looker Studio で Search Console と GA4 を統合し、アラート付きダッシュボードを構築すると便利です。数値の異常値をメールで自動通知することで、リライトタイミングを逃さず施策を高速回転させられます。

データ分析の具体例とレポート作成

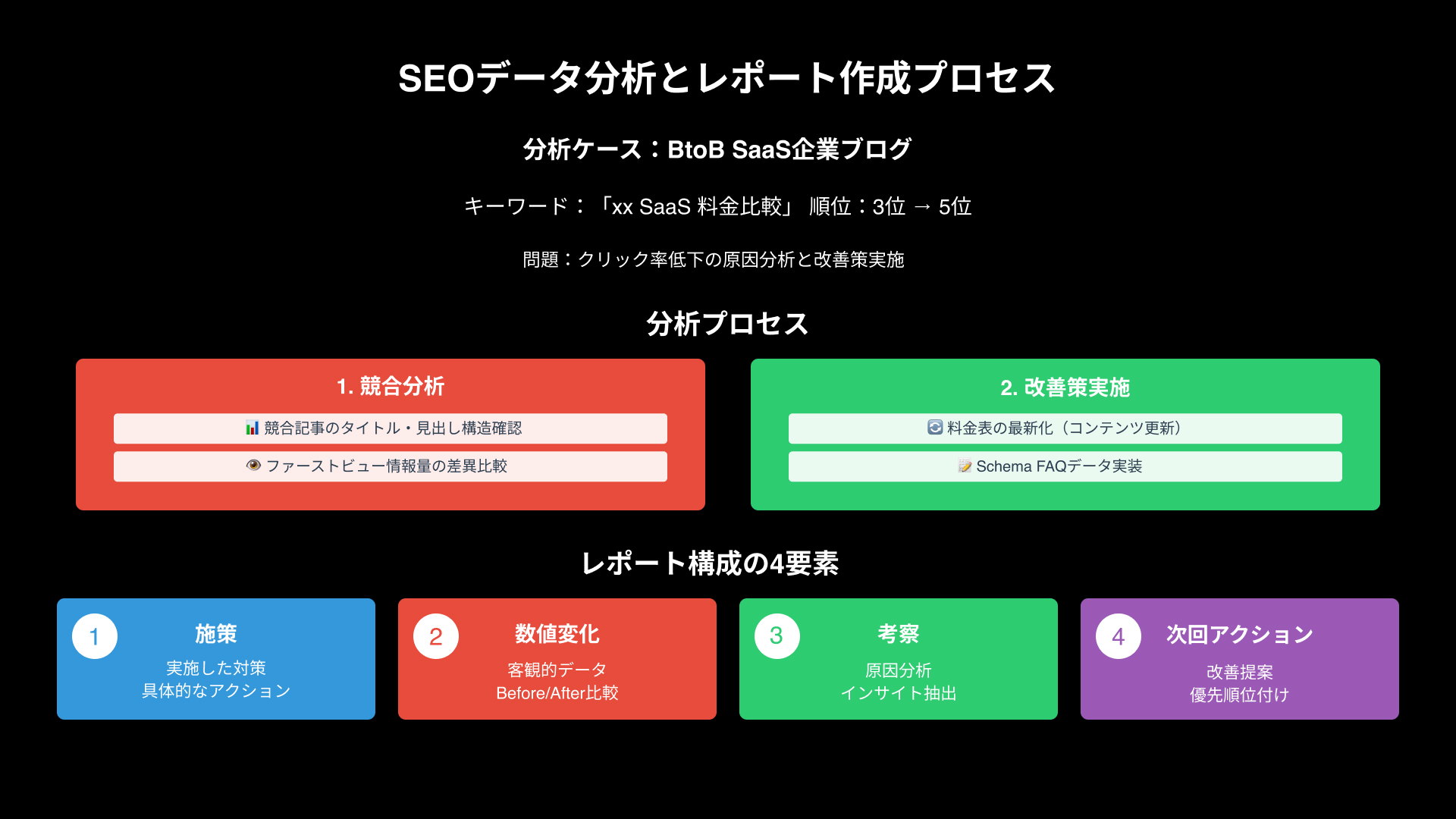

例えば BtoB ソフトウェア企業のブログ記事を想定しましょう。「xx SaaS 料金比較」というキーワードで 3 位から 5 位に順位が低下した場合、クリック率低下の要因を特定するために競合記事を分析し、タイトルと見出し構造の差異、ファーストビューの情報量、レビュー数などを記録します。その上で自記事へ料金表の更新、事例 CTA の追加、Schema FAQ の実装を行い、再クロールを促すために投稿日を更新して XML サイトマップを再送信します。

レポート作成時は、施策→数値変化→考察→次回アクションの 4 項目をセットでまとめると意思決定がスムーズです。特にファクトと意見を混同しないよう、スクリーンショットやデータソース URL を添付し、再現性を担保することが肝要です。

改善サイクルを回す運用体制

SEO は単発施策ではなく、継続的な改善体制が成果の差を生みます。編集担当、開発担当、デザイナー、営業の各部門が連携し、週次でタスク管理ツールを用いてステータス共有を行いましょう。特に開発リソースが限られる企業では、施策の優先度を「影響度×開発工数」で点数化し、バックログを整理すると効率的です。

定例ミーティングでは、前週の KPI 推移と次週の重点タスクを 15 分で共有し、残り 15 分でボトルネックの解消策をブレインストーミングする形式が効果的です。短時間で意思決定を行い、多人数での工数ロスを防ぎます。

付録: 実務で役立つリソース集

| カテゴリ | ツール名 | 概要 |

|---|---|---|

| クローラー | Screaming Frog SEO Spider | サイト全体をクロールし、ステータスコードやメタ情報を可視化 |

| ログ解析 | BigQuery + Cloud Logging | クロールログを分析し、Googlebot の巡回傾向を把握 |

| キーワード調査 | Ahrefs / Keyword Surfer | 検索ボリュームと競合指標を多角的に比較 |

| Core Web Vitals | PageSpeed Insights API | 指標値を定期取得し、ダッシュボードへ自動集計 |

| 構造化データ | Schema.org / Yoast SEO | FAQ・How‑to などの Schema 生成を効率化 |

| モニタリング | Looker Studio | GSC・GA4・CWV を統合してアラート設定 |

Tips: 社内教育用に Google の『検索エンジン最適化スターターガイド』を日本語訳した資料を配布すると、非マーケターの理解が一気に深まります。営業やサポート部門が SEO の基本概念を理解するだけでも、リンク獲得のチャンスが広がるケースは少なくありません。

さらに、進捗管理には Jira や Notion を併用し、「完了定義(Definition of Done)」を明文化すると品質担保が容易になります。改善タスクが定量指標と紐付いているかを都度チェックし、ナレッジベースへ記録する仕組みを整えておくと、担当者の異動や退職が発生してもノウハウが属人化しません。

最後に、英語圏フォーラム(Search Engine Roundtable、Moz Q&A など)を巡回し、アルゴリズム変動の速報やベテラン SEO の知見をキャッチアップする習慣を付けましょう。日本語ソースより早く情報を掴めるため、競合より半歩先の改善アクションを仕込むことができます。

まとめ

本記事では、SEO の基礎理論から最新施策、そして成果を測定・改善する運用体制までを幅広く解説しました。検索エンジンのアルゴリズムは今後も変化し続けますが、「ユーザーにとって有益な情報を高速かつ安全に届ける」という核心は不変です。まずは現状の課題を洗い出し、E‑E‑A‑T と Core Web Vitals の 2 大テーマを優先的に改善してみてください。その上で、データに基づくリライトと内部リンク強化を継続すれば、中長期で流入とコンバージョンを安定的に伸ばせるはずです。貴社の SEO 施策が次のフェーズへ進む一助となれば幸いです。

最終的に重要なのは、仮説と検証を高速で繰り返す「実験文化」をチームに根付かせることです。アルゴリズムはブラックボックスであっても、ユーザー行動データは常に可視化できます。変化を恐れずに試行錯誤を続ければ、SEO は必ずビジネス成長の強力なレバーとなるでしょう。